データセンター・ブームの「加熱」

バーナード・リー著

データセンターの運用温度の上昇は、光ファイバーの信頼性に影響を与えます。

ビッグデータ解析、クラウド、モノのインターネット:ICT(情報通信技術)業界のバズワードです。これらはすべて、世界中で隆盛を極めるデータセンター市場に拍車をかけています。シスコは、2018年までにワークロードの4分の3以上(78%)がクラウドデータセンターで処理され、22%が従来のデータセンターで処理されると予測しています。2013年から2018年にかけて、データセンター全体のワークロードはほぼ2倍(1.9倍)になるものの、クラウドのワークロードは同期間にほぼ3倍(2.9倍)になるという。クラウドデータセンターのワークロード密度(つまり物理サーバーあたりのワークロード)は、2013年には5.2であったが、2018年には7.5まで成長するという。

大きなチャンスには、大きな課題がつきものです。データセンター事業者に「データセンターの運営で最も困難なことは何か」と問われれば、誰もがデータセンターのHVAC(湿度、換気、空調)システムに関連するコストと答えるに違いありません。多くのデータセンターでは、HVACに関連する年間コストは数百万ドルに上り、エネルギーコストの上昇に伴い、多くのデータセンター運営者が削減を望む最も重要な項目となっています。しかし、なぜデータセンターでは空調にこれほどコストがかかるのでしょうか。データセンターはこれまで、1950年代から続く精密冷却技術によって、データセンター内の環境を24時間体制で厳しく管理してきました。しかし、エネルギーコストの上昇と差し迫った炭素税により、多くの企業がデータセンターのエネルギー効率と既存のデータセンター運営方法の前提を再検討しています。そこで、「データセンターは常に低温である必要があるのだろうか?

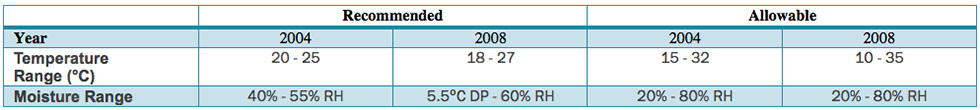

IT業界では、時間の経過とともに、温度と湿度の許容範囲を広げるための新しい技術革新に取り組んできました。一般的な使用条件よりも高い温度での動作は、電子・電気システムの信頼性に悪影響を及ぼすと広く認識されています。しかし、動作環境条件がITシステムの信頼性や寿命に与える影響は、運用者やITユーザーにはあまり理解されていないのが現状です。緩やかな環境エンベロープの使用は、データセンターの空調システムに関連する運用コストの一部を削減する可能性につながる。特に、機械式チラーを使用しないデータセンターでは、エコノマイザーを使用することで、建設費と運用費を大幅に削減することができます。そのような方法の一つが、「エアサイド冷却」として知られる自然空冷技術の利用です。節約効果はどの程度あるのでしょうか?ガートナー社のデービッド・カプチオ副社長は、温度を1°F上げると、月単位で約3%のエネルギーコストを削減できると試算しています。信頼性を損なわない理想的な温度とは?故障の可能性を高めることなく、どの程度の温度でデバイスを駆動させることができるのか?IT・データセンター設備業界に方向性を示すため、米国暖房冷凍空調学会(ASHRAE)は2004年に推奨湿度・温度レベルに関する最初のガイダンス文書を発表し、2008年にはこの文書を改訂して、表1に示すような新しい合意範囲を反映させました。

ASHRAEは、そのガイダンスの中で、2つの運用範囲を定義した。「推奨」と「許容」である。推奨範囲での運用は、周囲の温湿度条件がこれらの要素に影響を与える限り、デバイスのエネルギー消費を最小限に抑えながら、デバイスの信頼性と寿命を最大化することができます。許容範囲では、静電気放電(ESD)、腐食、温度起因の故障による「潜在的な信頼性リスク」をある程度受け入れながら、IT機器の許容範囲を広げ、その結果、IT機器の消費電力が増加する可能性とのバランスをとることができる。それにもかかわらず、業界では多くのベンダーがASHRAE 2008の許容範囲よりも広い温度と湿度の範囲をサポートしています。ASHRAE 2008のガイダンスは、あくまでベンダー間で合意された交差点を示しており、複数のベンダーの機器を同じデータセンター内で単一の運用体制で効果的に稼働させることを可能にしていることに留意することが重要です。2011年、ASHRAEは再びガイダンスを更新し、データセンターにおける2つの運用クラスを追加定義し、ベンダーとユーザーにそれぞれ最大40℃と45℃の高い運用許容温度境界を持つ運用定義を提供しました。

その中で、より高い温度での運用に注目しているのがGoogle社です。Google社のEnergy Program ManagerであるErik Teetzel氏は、「私たちがデータセンターのオペレーターに指導しているのは、サーモスタットを高くすることです」と述べています。グーグルは、2008年からベルギーデータセンターで冷却装置を使わず、自然空冷で運用しており、年間を通じて35℃まで気温が上昇する時期があります。人間にとっては暑すぎるが、機械は問題なく動き続けている。インテルとマイクロソフトの研究によると、ほとんどのサーバーは温度が高くても外気が入っていれば問題ないことが分かっており、ハードウェアの故障率が高くなるのではないかという懸念は緩和されている。実際、デルは最近、ASHRAEが推奨する動作温度より20℃も高い45℃までの環境で動作するサーバーを保証すると発表している。したがって、データセンターでより高い動作温度が世界的に採用されるのは必然的なことなのです。

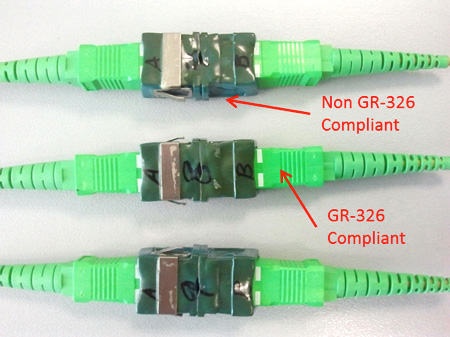

図3:環境試験に耐えられない規格外品

データセンターのパッシブインフラストラクチャーはどうなる?高い動作温度は信頼性への脅威となるのでしょうか?幸いなことに、45℃という動作温度はパッシブインフラにとって珍しいものではなく、定評ある部品メーカーは常にIEC 61753-1やTelcordia GR-326-COREといった国際規格に従って高温でのテストを行っています。これは、アクティブ機器の耐用年数が約 5 年であるのに対して、パッシブインフラの耐用年数は約 20 年であり、より新しいバージョンに交換されるまでの期間が短いため、パッシブコンポーネント(ジャンパーケーブル、トランクケーブル、コネクタ、アダプタ、ケーブルトランク、コンジ ットなど)はそれほど頻繁に交換されないため、妥当と考えられているのです。場合によっては、パッシブインフラストラクチャはデータセンターの運用開始時から存在しており、部品の故障が原因ではなく、必要な性能仕様を満たさないために交換されているに過ぎないこともあります(図3)。要するに、データセンターでより高い動作温度を採用することは必然であり、現在設計・設置しているものが、これらの新しい課題に対応できることを確認するだけです。